仅主机模式搭建hadoop集群

阿里云服务器搭建hadoop集群补充1 阿里云服务器选配

首先附上官网链接:阿里云官网

点击上边链接,注册后登陆官网,选择产品选项,然后选择云服务器ECS,就进入云服务器ECS购买界面。

进入云服务ECS购买界面,点击立即购买,在界面中分为一键购买和自定义购买,如何对配置没有概念,感觉太麻烦,推荐使用一键购买。本文以一键购买为例,主要是从以下几个方面进行选购:

- 地域及可用性

- 实例规格

- 镜像

- 网络类型(公网带宽)

- 购买数量(购买时长)

地域及可用性:选择离自己比较近的地域,如我在上海,选择华东2(上海),搭建hadoop集群的时候,购买的多台服务器一定要选择在同一个区域,避免后续配置麻烦。

实例规格: 选择CPU,及CPU运行内存,搭建hadoop集群的时候,master主机的运行内存必须是2G以上,其他节点可以为1G。我选购的3台云服务器的配置为:master:1 vCPU 2GiB,slave1:1 vCPU 1GiB,slave2:1 vCPU 1GiB。

镜像:选择服务器的系统和系统版本,系统可以选择CentOS和Ubuntu,版本无要求,我选择是 CentOS 8.0 64位。

网络类型(公网带宽):选择带宽,1-200Mbps都可以选择,我选择是1Mbps。

-购买数量(购买时长):选择购买数量和购买时长之后,付完款,就可以登陆了。配置越高费用越高。我选择的最低配置一个月:60元。

购买完成后,进入实例。选择远程登陆,输入自己的密码,即可进入系统。进入为命令行模式(黑窗口),不是图形化界面。登陆云服务器的方法,可以通过官网登陆,也可以通过SecureCRT或者Xshell等软件进行登陆,输入的IP地址(外网IP地址)和密码即可。

官网上的一个活动,有想法的可以参与一下。

阿里云大礼包领取

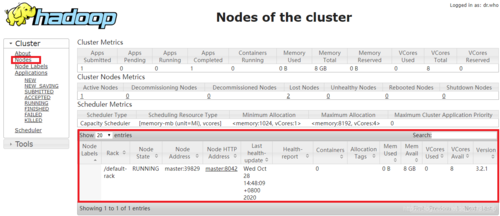

2 使用WEB界面访问hadoop集群

使用WEB界面访问HDFS和Yarn,该端口分别为50070和18088,这两个端口在这个文件中hdfs-site.xml、yarn-site.xml设置的。忘记的可以参考上一篇文章:阿里云搭建hadoop集群

使用WEB界面访问HDFS和Yarn的两个条件:

- 关闭防火墙

- 云服务器安全组配置端口

关闭防火墙命令:

|

|

#查看防火墙开启状态systemctl status firewalld#关闭防火墙systemctl stop firewalld#禁止开机启动防火墙systemctl disable firewalld#开启防火墙systemctl start firewalld#设置开机启动防火墙systemctl enable firewalld#重启防火墙systemctl restart firewalld123456789101112 |

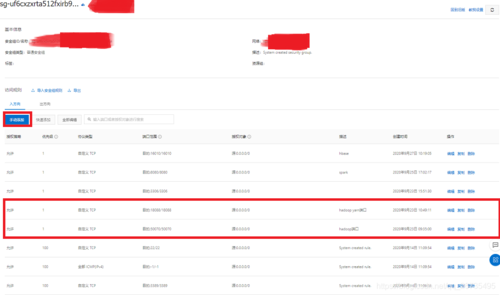

云服务器安全组配置端口:

进入控制台,选择自己已经开通的云服务器ECS产品,选择网络与安全,点击安全组,选择配置规则,然后选择手动添加,添加如上两个端口。

WEB界面访问HDFS和Yarn,直接在浏览器中输入外网IP地址:50070访问HDFS,外网IP地址:18088访问Yarn。

3 hadoop集群验证功能

HDFS功能测试:

上传本地文件到HDFS根目录,命令如下:

|

|

hdfs dfs -put spark-3.0.1-bin-hadoop3.2.tgz hdfs://master:9000 /#也可去掉hdfs://master:9000,core-site.xml中设置的hdfs名字。hdfs dfs -put spark-3.0.1-bin-hadoop3.2.tgz / |

本地文件上传到HDFS成功的话,会在web端Utilities下Browse the file system 中看到上传的文件,以及文件备份数,文件块大小,文件块的存放位置。

Yarn功能测试

运行一个jar任务,计算pi(圆周率)大小,命令如下:

|

|

hadoop jar /usr/local/hadoop-3.2.1/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.1.jar pi 10 10 |

找到hadoop文件下的mapreduce例子运行,会在web端看到job历史。

不求点赞 只求有用