- 写在前面的话

数学是一种思维,可以用在方方面面。可以隐性的在工程中使用,保证逻辑合理;也可以在显性的在机器学习中使用。数学是对数据规律的一种研究,哪怕在机器学习中也没有超出这个范畴(目前最火的神经网络,也只是矩阵变换的一种应用而已)。所以不用被’人工智能‘这个伪概念吓到。实践 理论基础,就可以学好机器学习。

- 微积分 泰勒级数

数学中极其强大的函数近似工具,

$$e^x \approx 1 x \frac{1}2x^2$$,在x = 0 附近成立

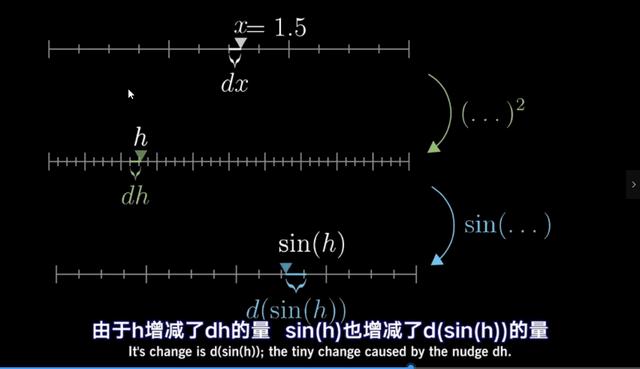

- 导数

定义:速度在瞬时会有变化率??有矛盾

这里的瞬时是指一个无限趋近于0,但是依然有长度的值。--微小变化量才是导数的本质。

链式法则

- 概率论

不支持在 Docs 外粘贴 block

- 期望

定义:离散型随机变量X的分布律为$$P\{X=x_k\}=p_k, k = 1,2,...$$,

若级数$$\displaystyle\sum_{k=1}^nx_kp_k$$,绝对收敛,则称此级数和为随机变量X的数学期望,记为E(X)。

即$$E(X)=\displaystyle\sum_{k=1}^nx_kp_k$$。

连续性随机变量X的概率密度为f(x),若积分$$\begin{matrix} \int_{-\infty}^{ \infty} xf(x)\, dx\end{matrix} $$绝对收敛,则称此积分值为随机变量X的数学期望,记为E(X),即E(X) =$$\begin{matrix} \int_{-\infty}^{ \infty} xf(x)\, dx\end{matrix} $$

性质:E(C)=C

E(aX)=aE(X)

E(X Y)=E(X) E(Y)

当X,Y相互独立时,E(XY)=E(X)E(Y)

- 方差

定义:设随机变量X的数学期望为E(X),若$$E(X-E(X))^2$$存在,则称它为X的方差(此时,也称X的方差存在),记为Var(X) 或D(X)。

离散型随机变量:$$Var(X) = \displaystyle\sum_{k=1}^{ \infty}(x_k-E(X))^2p_k$$

连续性随机变量:$$Var(X) = \begin{matrix} \int_{-\infty}^{ \infty} (x-E(X))^2f(x)d(x)\end{matrix} $$

计算方差常用公式$$Var(X)=E(X^2)-E^2(X)$$

- 数据归一化

设随机变量X的期望E(X)、方差D(X)都存在,且$$D(X)\not=0$$,

则称$$X^* = \frac{X-E(X)}{\sqrt[]{D(X)}}$$为X的标准化随机变量。显然,$$E(X^*)=0,D(X^*)=1$$

- 高斯分布

- 分布函数

$$P\{{x_1

- 均匀分布

- 指数分布

- 联合分布 边缘概率密度

- 协方差 协方差矩阵

定义:设$$X=(X_1, X_2,...,X_n)'$$为n维随机向量,并记$$\mu=E(X_i)$$,$$C_{ij} = Cov(X_i, X_j) (i,j=1,2,...,n)$$则称

$$\mu=(\mu_1,\mu_2,...,\mu_n)'$$为向量X的数学期望或者均值,称矩阵

$$C= \begin{Bmatrix} C_{11} & C_{12} & ... & C_{1n} \\ C_{21} & C{22} & ... & C_{2n} \\ \vdots & \vdots & \cdots &\vdots \\ C_{n1} & C{n2} & \cdots & C_{nn} \\ \end{Bmatrix}$$为向量X的协方差矩阵。

- 切比雪夫不等式

定义:设随机变量X具有数学期望$$E(X)=\mu$$,方差

$$D(X)=\sigma^2$$,则对于任意正式$$\varepsilon$$,不等式$$P\{{|X-\mu}| \geq \varepsilon\} \leq \frac{\sigma^2}{\varepsilon^2}$$成立

应用:切比雪夫不等式可以使用人们在随机变量X的分布位置的情况下,对时间发生的概率做出估计。

- 中心极限定理

中心极限定义是阐述大量随机变量之和的极限分布,是正态分布的一系列定理的总称

该定律表明,当n足够大时,独立分布的一些列随机变量的算术平均值接近(以概率收敛于)数学期望,即平均数具有稳定性。

- 矩估计

- 极大似然估计法

- 思想:寻找最想真实分布的那个分布

- 应用逻辑回归的参数估计

- 定义:设离散总体X=x的概率为$$p(x;\theta)$$,其中$$\theta是未知参数$$

$$x_1,x_2,...,x_n是一组样本观测值,则称:\\L(\theta)=\prod_{i=1}^{n}p(x_i,\theta),即\\ P(X_1=x_1,X_2=x_2,...,X_n=x_n)=p(x_1,\theta) \cdot p(x_2,\theta)\cdots p(x_n,\theta)为似然函数 \\ 称L(\hat\theta)=maxL(\theta)为最大似然估计值$$

- 贝叶斯法则

- 线性代数 向量的范式

- 优化 线性规划 梯度下降 批量梯度下降BGD 随机梯度下降SGD 小批量梯度下降MBGD 牛顿法

- 泰勒公式

- 拟牛顿法

- 共轭方向法

- 动量梯度下降法

- 均方根优化法

- Adam算法

- 距离度量 欧式距离 修正欧式距离 曼哈顿距离 海明距离 角度度量

- 关于数据中哪些需要背诵 定义是需要背诵的; 性质是不需要背诵的;对于证明题,我们不用去背诵用了哪些性质,只需要背诵定义和结论即可。 定义,还是定义。定义不会改变,但是性质总是不断的扩展。