我写过不少关于量子计算的文章,实际上主要是两类:一类是基于量子门的计算,另一类是绝热量子计算。其实还有第三种,叫做“量子行走”。

所谓量子行走,用自然界的例子来说,就是光合作用过程中电子转移的工作原理。

当前,研究者已经能够催动整块的原子云“齐步走”,实现量子行走。

光可以实现量子行走,但需要配备一台新式计算机来算出每一步。

不过,在玻色-爱因斯坦凝聚态下,光和物质的关系都反过来了。研究人员就是通过这个原理实现了玻色凝聚态下的量子行走。

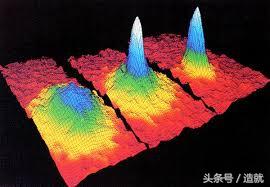

图为计算机中的玻色-爱因斯坦凝聚模型,类似波的特点清晰可见。

三类量子计算机进入正题之前,我想先对不同类型的量子计算机做一番简要的比较。量子门是大家最熟悉的,就是通过一个量子门的集合来完成严谨的逻辑运算,末端读出结果。

绝热量子计算则不涉及严谨运算,而是将问题转化为实现某一能量景观的最低能耗,打个比方,解决方案就在丘壑地区的深谷之中。

思路是这样的:先从一片平滑的碗状地带入手,逐渐制造出“山陵”,直至量子位落入最深的“谷底”,计算结束。读出量子位的值,问题就解决了。

而量子行走跟量子门、绝热计算都不一样。

对于量子行走来说,问题转化为一系列的线路。

一个量子态将同时出现在所有可能的线路中,但各条线路会相互干涉,而包含了答案的那条线路出现量子态的概率更高,其他线路的概率则较低。换而言之,先放进一个微观物体——比方说一个光子,然后测量光子出现的位置,就能找到答案。

此时的思路是这样的:制造一套相互关联的线路,将有待解决的问题编入其中。

如果说一个光子是一个量子位,那么光纤就是实现上述方案的材料。

先使光纤相互耦合,确保量子位沿多条线路游走并自我干涉。耦合的强度决定了每一根光纤中光子的“数量”,而光纤的长度决定了干涉的性质是有益还是有害。

光的量子行走固然好,但每一根光纤须得维持不变:光纤的长度以及不同光纤之间的耦合强度无法及时调整。说到底,这种基于光学量子行走的计算机,缺少可编程的因素。

像光一样流动的物质在玻色-爱因斯坦凝聚态下,光和物质扮演的角色可以互换。

所谓玻色凝聚,指处在同一量子态的冷原子的集合。

简而言之,该集合的行为就像单个粒子一样整齐划一。这时候如果用脉冲光对其加以轰击,这颗“粒子”将以一定频率震颤,导致漂移。至于漂移的方向,取决于玻色凝聚的内部状态。

玻色凝聚的内部状态是由微波脉冲设定的。

比方说,适当的微波脉冲会令玻色凝聚态处在两种量子态的叠加态。此时如果再用激光脉冲加以轰击,玻色凝聚就必然因叠加态而同时向两个方向移动。

研究者证实,只要依次施以微波和激光脉冲,就能像经验丰富的弹球玩家一样,随意控制玻色凝聚的空间线路。

不同的是,这里是量子弹球——每当玻色凝聚撞到反弹杠,就会同时向多个方向反弹,再撞到更多的反弹杠。更复杂的是,量子弹球会穿越不同的线路,再在各类节点重新组合。线路交叉之处,玻色凝聚发生自我干涉。干涉会导致在某些线路上找到玻色凝聚的概率降低,而在另一些线路上的概率上升。量子计算恰好需要这个。

把光变成固体光的量子行走尚且需要玻璃纤维以固定的方式、(在交汇点上)以固定的长度相互耦合,而玻色凝聚则更为灵活。脉冲光可以推动玻色凝聚在自由空间行动,而微波脉冲则如同各条线路之间的耦合器。脉冲光的数量,决定了行动线路的长度;而微波脉冲的强度,则决定了各条线路的耦合性。这是重点。

玻色凝聚态下,量子行走的路线是可编程的。因为光也好,微波脉冲也好,都不是一成不变,可以随时调整。

只不过,这样的计算机还没造出来。

科学家虽已证明了对单个玻色凝聚实现量子行走的可能,但还没有证明他们能够在量子行走中对某个问题进行编码。

据我所知,在量子行走中对问题进行编码,难度不小。必须设定好各个微波脉冲、分别对应不同行走线路,才能造出计算机。再以光纤为例。在光学量子行走中,如果光子同时进入左右两条线路,那么左边那条线路就会受制于右边那条线路的长度和耦合度。但是,在玻色凝聚中,不同线路之间相距无几,根本不能使微波脉冲对准具体任何一条。换句话说,微波源将不可避免地修改整个玻色凝聚的内部状态。

话说回来,现在毕竟有了好的开端。玻色凝聚态下的量子行走,有利于将量子门和绝热计算的优势结合起来。

其一,玻色凝聚是在真空洁净环境下,靠的是中性原子,有可能形成高度可靠、长期存在的量子位。在这个意义上,玻色凝聚更像是离子阱量子计算机。

其二,它既有望解决更复杂的难题,又不必专门处理大量的量子位,倒更像是绝热量子计算的方法,发展前景可期。

- 本文作者Chris Lee系荷兰方堤斯应用科学大学教师。

翻译:李芜

校对:李莉

编辑:漫倩

来源:arstechnica

造就:剧院式演讲,发现创造力更多精彩内容,敬请点击蓝字“了解更多”。

,