在7月28日的「QingCloud Insight 2017」上,麦思博(msup)组织了主题为“AI落地实践”的专场论坛。搜狗语音交互技术中心研发总监 陈伟 在本场带来了题为《从语音识别到语音交互》的演讲。

本文为早餐君根据速记整理而成,在不改变讲者原意的情况下做了编辑和缩略。特别感谢青云QingCloud、麦思博(msup)、搜狗同学的贡献。

陈伟:搜狗语音交互技术中心研发总监,语音技术负责人,负责搜狗语音识别、语音合成、机器翻译、声纹识别、手写识别等多项技术的研发工作,同时负责搜狗知音引擎语音技术的研发,致力于通过技术和产品的创新提升语音交互品质,为用户提供优质的语音使用体验。

以下为陈伟的演讲内容。

我叫陈伟,来自于搜狗语音交互技术中心,主要研究语音方面的技术应用,很高兴与大家分享搜狗语音所做的工作。我们团队是在2012年成立,主要做语音识别,用于搜狗的手机输入法上。

移动互联网兴起以后,手机成为人的一部分,使用键盘做输入的方式在很多情况下不方便,所以语音会成为很重要的输入方式。

这张图可以看到引发深度学习和技术驱动产品主要有三方面的因素。首先有大量的数据,现在搜狗输入法一天差不多22万小时原始数据。

其次,深度学习算法,最早期是深度神经网络,到循环神经网络,以及序列模型,各种模型复合在一起的复杂算法。现在这个圈子很活跃,每天都有很多论文出现。

再者,跟计算有关,当大量数据以及复杂算法出现后,就会考虑如何能在可控时间范围内,稳定产出好的模型、能力,这就依赖于运算。

最初,数据很少,更多依赖于几块卡或者单卡,GPU卡,到现在是上百万卡。从G级别,演变到P级别的运算能力。数据、运算、算法,三个因素共同驱动了技术从不可为变成可为。

这是近几年用到的主要算法,有很多模型,从端到端,更多的避免了复杂的流水线处理,直接是目标驱动的算法。

深度学习领域,在往深和宽两个维度发展,搜狗在语音方面做到50多层的CN(神经网络)结构,以及各种复合结构,序列到序列,这个结构在翻译(应用)上已经成功。在语音应用方面也在不断尝试,算法方面变得更深更宽。并且,新的网络结构在不断出现。

运算方面,如何更好的将多块GPU组合起来,更好的驱动多卡的框架。搜狗在内部也有自己的深度学习平台,解决了不同结点之间的通信和数据传输,以及各种各样的神经网络结构。

搜狗语音识别的主要应用场景

在上述因素的共同驱动下,搜狗基于语音识别能力的线上输入法错误率大幅下降。自从2012年开始在搜狗输入法上使用,到现在,语音识别落地的场景主要分两种类型:听写,转写。

听写,人对着麦克风说话,随着语音的不断录入会实时出现文字,更多的是强调低延时的语音结果输出。

转写,更多是有了大量的语音数据,如何离线产生语音识别结果。

主要用在什么场景?听写主要在演讲,产品叫搜狗听写,在大会或者演讲场景,演讲者不断说话,屏幕上会实时出现结果,从今年起已经支持了近百场的规模。

直播,教育机构的线上教育,老师讲课,以前是学生记笔记,现在是语音识别把老师讲课的内容识别成文字,当直播课程结束以后,可能出现一个二维码,学生只要扫码就可以得到老师讲课的全部笔记。

法院,以前在庭审的过程中法官和嫌疑犯在沟通过程中书记员需要记录,现在两个麦克风可以解决这个问题,法官和嫌疑人每个人面前都有一个麦克风,实时把内容转化为问卷。

医疗,医生病例的整理。金融、电信,主要是客服,比如有大量客服数据,需要监控客服质量,以及客服和用户的对话过程,这些场景下正在逐渐使用转写的技术。

语音识别更好地提升了输入的效率。

除此之外,我们团队也在做一些其他技术,例如如何把语音和其他技术结合起来。给大家举两个目前在做的比较重要的项目。

一个是搜狗机器同传技术,希望辅助人工同传,在今年的很多演讲场合会出现搜狗同传。(展示了王小川在乌镇互联网大会上演讲时搜狗机器同传的场景)。不只是中文语音转化为中文文本,还将英文翻译成中文。另外,就是语音识别、理解、合成组成的语音交互技术。

智能语音交互——搜狗知音引擎

接下来聊语音交互。搜狗从去年开始提出了自己的人工智能战略:自然交互 知识计算。搜狗的使命就是让用户表达和获取信息更简单。自然交互和语音交互过程中核心在于语言,除了语音作为主要模态,更多是多模态的输入,包括语音、图象。当语音->语言的时候有语音识别,语言和语言之间是翻译,跨语言的交流。

语音交互,2011年苹果推出Siri以后,国内大规模出现了助手类产品,搜狗语音助手在2013年推出,在业界做的不错。可以看到它大致的能力,讲个笑话,说我要找卫生间,它会直接推送一个肯德基,让你知道肯德基有卫生间。

业界这种助手类的产品到后来证明是失败了,基本上没有存活下来。主要原因有几点,所谓通用的云技术能力远远达不到通用的能力,大家想把这个事做的没有任何的产品边界是比较难的。另外到底有没有命中用户的刚需,用户有没有很强的意愿每天打开助手做各种各样的交互。在去年,我们把语音交互的解决方案叫作搜狗知音引擎。

我们把知音引擎限定在三个范围:车里、客厅、户外。

刚需场景主要在于它怎么解放双手,甚至有时候解放双眼。开车时手被方向盘绑定必须要使用语音;在房间客厅里够不着很远距离,同时可能像音响这种连屏幕都没有,必须使用语音;在户外走路可能用键盘打字特别不方便,甚至不安全,可不可以使用语音。

复杂场景下解决语音识别的四个“杀手锏”

如何做好语音交互,是不是把这三项技术简单串联起来就可以了?这是前年春节时候一个山东大汉的视频,大家看一下。

这么搞笑的效果是山东口音造成的吗?不是,对于语音识别,口音是一方面,另外是噪声。在很强的口音,以及噪声很大的环境下对于识别准确率依然是很沉重的打击。

语义理解上,能否支持多轮对话。有的场景是问北京天气怎么样,它会给一个答案,你接着问明天、后天、上海的呢?问了一圈机器就蒙了。纠错,刚才示例中一个很大的问题就是错了无法纠正。此外,很多方案是基于模板做的,如何能精确理解人的自然语言。

另外,全双工的持续交互。所谓的全双工就是我在听你说话的过程中,我会实时打断你,双方之间是并行处理的两个通道,如何解决?不能简单优化某个单点能力,而是通过组合成有效的整体系统能力。

分开来看,对于识别这件事情。之前说在搜狗输入法上达到2.5亿次请求的场景更多的是近场语音听写过程,拿着手机离嘴很近才会说,可以天然地规避很多噪声。

当扩展到车载、智能家居场景下,其实把人和设备的距离拉的比较远,比如对着音响,或者对着车载设备至少是接近于60公分或者一米以外的距离。对于高噪环境下的语音交互可能是未来语音交互的主要场景。

如何去解决呢?我列了几个关键点。

第一,单麦克风和多麦克风的阵列算法。解决噪音,业界有很多算法,对工业界来说,麦克风阵列已经成为标配,如果想做好场景,麦克风阵列能更好地获取目标说话人方向的声音,而不是全方位的声音。它可以做说话人的声源定位,很好地把空间切割开,告诉目标说话人在哪个位置,我的阵列指向你,获取语音。

第二,回声消除和打断。我们对着设备说话的时候,其实麦克风收到的声音是音乐加了说话的声音,或者是机器的声音加上说话的声音,是混合在一起的声音。如何把机器的声音去掉只留下我的声音,其实就是回声消除,有了这个能力之后可以稳定获取到人的声音,有了多麦克风阵列可以做到远距离的识音。

第三,语音唤醒和离线识别。语音唤醒在于如何能够把机器的语音助手调起来,要说一些唤醒词,大家会看到最近业界疯狂发布了很多音箱,区别在唤醒词(能力)。

离线识别,对于很多场景很重要。我们很难永远联网,开车到某偏远地段,想用语音控制的时候,没有网络就干不成。离线的好处是不用联网,基本忽略网络延迟的能力。搜狗在离线方面会把任务限定在一些命令词上,比如帮我调低音量等等,这样准确率能够得到保证。

第四,声纹识别。这是在以上三个通用能力之外的个性化能力,具体是指,会区分不同的人来做这件事情。比如今年和一些电视厂商推了很多语音方案,就涉及到面对小朋友在使用电视的时候,是否要加儿童锁,首先要判定是不是小朋友。或者,当有一个人对着电视在说什么的时候,可以判定你是谁,比如喜欢看爱情片,下次再说的时候给你推荐很多的爱情片。

从可用到好用 更智能的交互和服务

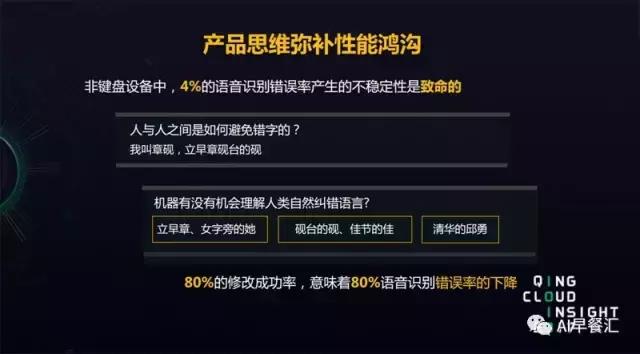

除了技术之外,产品能做什么?现在语音识别还做不到百分之百,准确率可能再提升几个点,能从一个可用到好用的状态。语音最大的问题在于人们在说的过程中,结果有很强的不确定性,无法预期是否有错,纠错的时间,或者纠错的成本非常高。

我们用产品思维去思考,能不能弥补这些缺陷。比如,如何去避免错字,我叫章砚,因为存在多音字,我会说立早章,砚台的砚。机器有没有可能理解人类自然纠错的语言。

我们去年首先在搜狗输入法发布了语音纠错能力,大部分能力来源于搜狗的输入法和搜索的能力,比如说单人旁的他,立早章,这些偏旁部首的描述,还有嘉节的嘉,组词的方式,用了知识图谱的能力。在这些能力共同作用下,希望用产品的方式弥补目前语音识别可能出现的一些错误。

这个能力在刚刚发布的一款搜狗地图导航里已经使用了。举个例子,北京有一个同音的小区叫风(枫)林绿洲,一个大风的风,一个枫叶的枫。我们的助手会弹出,有两个地名,一个是风林绿洲在哪儿,还有一个枫林绿洲在哪儿。我们支持另外一种说法我要去枫林绿洲,枫叶的枫,这样可以降低交互成本。纠错能力对于交互依然非常重要。

除此之外,因为场景逐渐从通用变成垂直,如何对接到不同垂直场景下的内容和服务非常重要。现在针对人机交互,除了多轮对话和知识图谱的能力之外,我们主要是依靠搜狗各种各样的产品日志、数据,比如生活信息、娱乐消费、知识问答,这是搜狗目前已经有的。

有了刚才说到的语音识别、理解、合成能力,给大家看一下我们在两三个月之前做的一款智能车载后视镜,会在下半年发布。

过程中秀的是多轮交互能力,中间不断转换主题,不停的打断,机器在对话过程中可以随时打断他,机器可以终止自己的播报,切入下一个话题。

,