科幻作品中AI有自主意识的一幕似乎正在出现。

据多家媒体报道,联合国利比亚问题专家小组日前发布的一份报告称,在2020年3月利比亚民族团结政府与哈夫塔尔领导的军队发生战斗期间,土耳其制军用无人机自主追捕、攻击了人类。

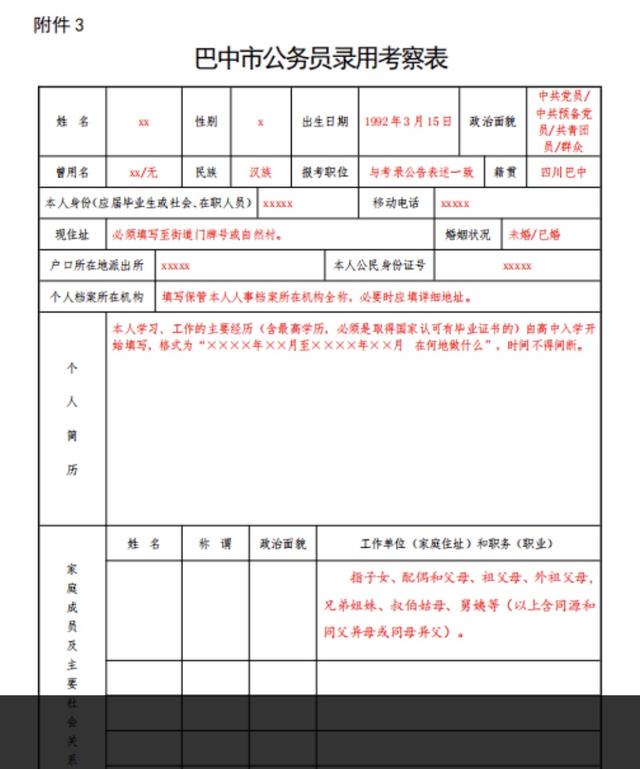

KARGU-2(卡古2号)。图片来源:STM公司官网

报告中写道:“哈夫塔尔的军队在撤退时,遭到了无人机KARGU-2(卡古2号)等致命自主武器系统以及其他巡飞导弹的追捕和远程攻击。”

美国国防大学研究员扎卡里·卡伦伯恩在《原子科学家公报》上写道,“如果有人在自动袭击中丧生,这很可能是历史上已知的首个使用基于人工智能的自动武器进行杀人的案例。”

军用无人机技术上早已能够自主攻击

无人机参加军事行动并不鲜见。2020年阿塞拜疆和亚美尼亚之间45天的纳卡战争中,阿塞拜疆军队使用的土耳其产TB-2无人机和以色列Harop自杀式无人飞机就已大出风头。但这些军用无人机都由后方人员操控,而非自主行动。

而联合国这份调查报告称,KARGU-2这种“致命的自主武器系统被编程来攻击目标,而不需要操作员和弹药之间的数据连接,机上装载炸药,能够对目标进行自杀攻击,并且在撞击时引爆。

这等于是说KARGU-2疑似成了“杀人机器人”。

KARGU-2制造商土耳其STM公司的资料似乎变相证实了联合国报告的判断。该公司称,无人机可以使用“机器学习”和“实时图像处理”来对付目标。

资料显示,这款无人机的传感器具备景象识别或人脸识别功能,可由地面控制人员进行控制,或自主杀伤,并可以组成编队展开“蜂群”攻击。

俄罗斯媒体引用无人机领域专家的话说,无人机自主决定猎杀有生力量,这在技术上是可行的,出现这种情况也仅是时间问题,关键是,哪个国家会第一个打开这个“潘多拉魔盒”。

冲击“机器人三定律”

当然,也存在另一种可能:在2020年3月利比亚内战的这场战斗中,KARGU-2其实是由利比亚政府军在后方操纵的。

只是因为使用KARGU-2是公然违反联合国决议的行为,所以干脆把责任推到了无人机自主攻击上,以免外交上被动。

根据联合国安理会1970号决议第9条,对利比亚内战双方是实施武器禁运的。决议要求所有会员国禁止“直接或间接向利比亚民众国供应、出售或转让任何类别军火或相关军用物资,包括武器和弹药、军用车辆和装备、准军事装备及上述物项的备件”。KARGU-2是土耳其制造,使用归使用,但使用者未必想渲染此事。

但假如确实当时发生了无人机自主攻击人类的事,问题就严重了。

著名科幻作家阿西莫夫在1950年出版的小说《我,机器人》中描述人工智能的世界时,提出了“机器人三定律”。即机器人不得伤害人类个体,或者目睹人类个体将遭受危险而袖手不管;机器人必须服从人给予它的命令,当该命令与第一定律冲突时例外;机器人在不违反第一、第二定律的情况下要尽可能保护自己的生存。

后来,“机器人三定律”被公认为确定了人类和AI的基本关系。其不仅为后世的《终结者》《黑客帝国》等一系列科幻作品提供了灵感,也成为人类发展AI技术的守则。

现代军事技术发展绝非只有军用无人机能够通过传感器自动锁定并攻击目标,冷战以来,其他类别的致命武器都在研究开发中,远远走在了民用前面。

其实,不管无人机自主攻击人类一事是真是假,联合国的这份报告都在提醒人们:未来,“机器人三定律”究竟能不能守得住,还要划个大大的问号。

没有有效的国际法可以制约

与核武器不同,像军用无人机这样的武器很容易制造和流通。如果AI在军用无人机这样的装备上得到无限拓展使用,无人机可以更快地自主学习的时候,国际安全体系将面临巨大风险。

核武还有《核不扩散条约》的制约,全球绝大多数国家都加入了这一条约,而对军用无人机这样的致命武器,目前没有有效的国际法能制约。

其实国际社会有识之士也做过努力。上世纪90年代,联合国《特定常规武器公约》生效,后来有识之士希望把伴随科技发展出现的新型致命武器纳入其中。2018年,联合国召集开过《特定常规武器公约》会议,88个国家和地区的代表在会上就“致命自主武器系统”达成了10项“可能的指导原则”。

其中第二项规定:“人类必须保留使用武器系统的决策责任,因为责任不能转交给机器。”但这个公约只是提倡,没有约束力。美国、澳大利亚等国还阻止就禁用“杀手机器人”达成具有法律约束力的国际公约。

从这个角度看,“致命自主武器系统”在未来带给人类的危险,其实是人类带给自己的。我们对未来科技的期待,不应该包括这种危险。

□徐立凡(专栏作者)

编辑:马小龙 实习生:叶可慧 校对:赵琳

,