智东西(公众号:zhidxcom)

作者 | 云鹏

编辑 | 漠影

曾经,一部相机基本只能用来拍照,但当相机放在了智能手机上以后,它便拥有了“认识你”的能力。

而今天,在智能手机之外,包括摄像头、麦克风以及各类传感器在内的硬件被用在各式各样的硬件产品中,智能终端的概念开始被更多人所认知。

电视摄像头可以捕捉你的健身动作并给予指导、耳机可以听懂你原本陌生的语言并实时翻译……

在这些智能、便捷的体验背后,AI技术已经润物细无声般地走入了我们每个人的生活,而这些终端设备,借助AI技术,拥有了理解环境、进行判断,并进一步行动的能力。

今天各类设备都在变得越来越智能,图片来源:高通

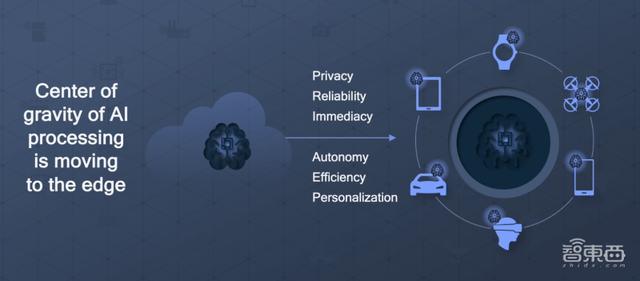

从曾经远在云端的AI,到今天走入边缘侧,逐渐落地于我们身边各类终端设备侧的AI,一场正新的变革正在AI产业中酝酿。

就在最近的WAIC世界人工智能大会上,高通通过一系列软硬件层的技术突破,在证明自身AI技术实力的同时,向业内传递了一个明确的信息:端侧AI将依然是AI发展的主要方向之一,而AI在终端侧的应用,已经成为高通AI技术落地的核心突破口。

高通对于端侧AI的发展是如何思考的?未来端侧AI的发展将面临哪些挑战,我们又将如何破局?高通产品管理副总裁Ziad Asghar已经给出了答案。而由这些深入思考,我们可以更好地把脉端侧AI未来的发展。

高通产品管理副总裁Ziad Asghar

一、端侧AI优势凸显,如何“吃的更少干活更多”是难点

究竟什么是端侧AI?其实小到我们日常用的智能手机、智能耳机、智能手表,大到智能汽车,这些智能终端产品本身,就是端侧AI很好的应用案例。

近五年来,全球云服务和服务器市场的增速都有明显的放缓趋势,重金建立服务器机房、大规模扩张云服务的时代或许已经过去。

在这样的大背景下,云端AI也开始加速走向边缘和终端侧,AI在各类产品、行业中的应用,开始进入“精耕细作”模式。

为什么AI在终端侧应用开始愈发受到青睐?其实相比放在云端或者边缘的服务器中,AI在终端侧应用的优势还是比较明显的。

首先最明显、与我们关系最为密切的一点就是数据隐私安全。AI运行于端侧,可以让数据留在端侧成为可能。整个AI处理链路中的数据都可以放在本地计算、存储,这对于数据安全和隐私保护无疑是有利的。

此外,端侧AI让AI处理任务的及时性得到保障,可以最大限度的降低时延,实现快速响应并反馈输出。

AI处理的重心正在向边缘转移,图片来源:高通

最典型的就是车载场景,汽车对于路面情况的判断,需要做到毫秒级,因此端侧处理的重要性就更加凸显了出来。

当然,AI于端侧运行也会让整个方案更加灵活,支持更多定制化功能,针对用户面对的具体场景做出调整。

既然端侧AI这么“香”,大家直接用不就好了?事实当然没有这么简单,端侧AI发展面临的最核心挑战,就是如何让AI模块在既定功耗下,完成更多AI任务的处理。

任何离开功耗谈智能设备可以实现的功能,都是不切实际的。

正是看到了端侧AI的巨大优势以及目前行业发展面临的核心痛点,高通决定将打造智能网联边缘作为自己当下重要的专注领域,助力AI落地端侧也成为高通的核心目标之一。

因为高通核心优势之一,就是能让AI“少吃饭,多干活”,让AI可以更高效地应用在各类硬件产品中。

在去年11月的高通投资者大会上,高通总裁兼CEO安蒙首次提出了高通接下来将要贯彻的 “统一的技术路线图”,而这一战略将整合高通端侧AI、高性能低功耗计算和5G连接等方面的优势,为智能网联边缘领域的玩家提供技术解决方案,让高通的AI能力可以规模化地扩展到各条赛道中。

高通总裁兼CEO安蒙在2021年高通投资者大会上,图片来源:高通

正如安蒙所说,凭借“统一的技术路线图”,高通会将AI、影像、图形、处理和连接等技术优势,带给包括智能手机、平板电脑、XR眼镜、PC和汽车在内的几乎所有终端产品。

二、深耕AI十余年,硬件软件两手抓,两手都要硬

当然,这样的统一技术路线图,并不是纸上谈兵就能够实现的,这需要持续的研发投入和技术创新,需要软硬件两手都要硬。

作为全球智能手机高端芯片市场占有率第一的玩家,高通为人所熟知的一面是他们在手机行业推出了各种旗舰移动芯片,但实际上,高通是AI领域的“隐形大佬”,高通已经在AI领域深耕了十余年。

高通利用自身的AI能力核心做了两个方面的事情:第一,增强现有体验;第二,创造新的体验。

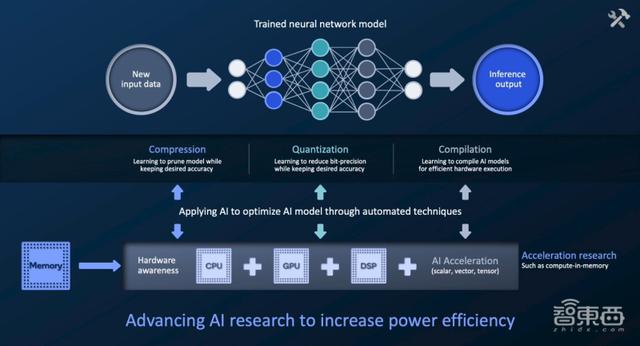

高通的AI研究,图片来源:高通

首先,增强现有体验很好理解,现在不论是影像、视频、音频、VR/AR还是通信领域,AI技术都已经深度介入,而高通在这些领域,都积累了成熟的AI解决方案,用来提升实际的用户体验。

如何提升体验?用最简单的话来总结AI发挥的作用,就是AI会帮助终端设备提升处理任务的能力和效率。

推动AI研究提升能效,图片来源:高通

比如同样是图像优化,相比传统算法,基于深度神经网络的AI模型可以更加高效地对图像进行类似语义分割的处理。同样是处理一张手机拍摄的照片,AI可以让处理效率更高、能耗更低、同时效果更好。

再比如当我们身处漆黑一片的夜晚时,通过AI算法对于拍摄全链路的优化、出色的降噪能力,手机可以获得更强的暗光拍照能力,甚至可以化身“夜视仪”。

而另一方面,在提供创新体验层,高通与其枝繁叶茂的生态系统玩家进行合作,利用软硬件技术,在智能手机、PC、汽车等不同产品中寻找差异化体验,从而形成高通自己的独有优势。

做生态,就离不开对于开发者生态的赋能。就在今年6月,高通发布了自家首个统一的高通AI软件栈(Qualcomm AI Stack),我们可以形象的将其理解为高通AI开发“百宝箱”。

高通AI软件栈,图片来源:高通

基于高通公司所有业务线产品组合的任何软件开发,开发者们都可以从中找到所需要的技术、工具以及接口。

1、高能效比和灵活扩展能力成为高通AI引擎关键优势

不论是对于现有终端设备体验的提升,还是基于生态对产品体验做出的创新性探索,我们都能够看到AI在端侧展现出的极高价值。

而实现这样出色的AI端侧表现,与高通在软件硬件层面的深厚积累密不可分。

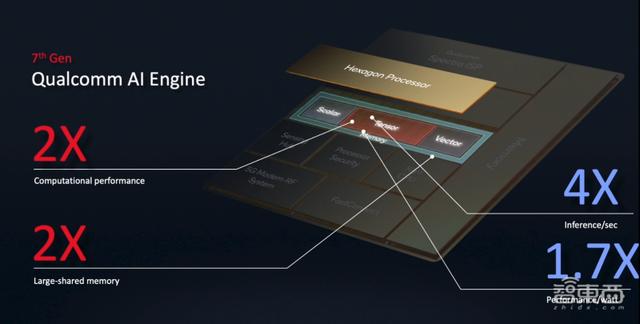

在硬件方面,高通去年推出了最新的第七代高通AI引擎,其中Hexagon处理器的AI性能给人留下了深刻印象。

Hexagon处理器由标量、张量和矢量加速器组成,三个加速器使用统一的共享内存,高通将张量加速器的计算性能提升了一倍,同时共享内存的容量也提升了一倍。

在具体AI应用表现方面,第七代高通AI引擎的推理速度是前代的4倍,能效提升幅度达到了70%。可以说是真正的“吃的少,干的多”。

Hexagon处理器,图片来源:高通

究其原因,第七代高通AI引擎解决了前文提到的端侧AI落地核心痛点:如何在既定功耗下完成更多的AI处理。在各种AI测试中,不论是峰值性能还是能效比表现,第七代高通AI引擎一直是“霸榜”般的存在。

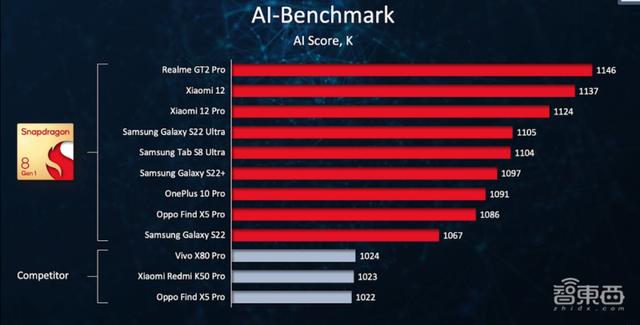

AI性能测试排行榜(智能手机端),图片来源:高通

特别值得一提的是,除了高AI能效比,第七代高通AI引擎还具有灵活扩展能力。

今天,AI技术所要面对的智能终端品类已经极大丰富,从手机、AR/VR眼镜、PC、各类物联网产品到智能汽车、边缘云终端。

如何将自身的AI硬件解决方案高效扩展至所有不同产品线,如何解决不同产品对于性能、功耗差异明显的需求?是高通必须要面对的挑战。

高通AI硬件解决方案的优势及特性,图片来源:高通

目前,高通的AI硬件解决方案已经实现了从500毫瓦到15瓦的性能水平扩展,甚至可以满足200瓦的性能水平。

要知道,除了性能和功耗需求的不同,各类终端产品所需的深度学习架构和算子也差异巨大。比如智能手机需要使用生成模型、计算领域要用到Transformer模型,汽车ADAS则需要激光雷达模型。

此外,各类终端产品对于AI特性的需求也不尽相同。比如汽车和XR需要支持更多的并发场景。

为了解决这些AI能力需求上的差异,高通在Hexagon处理器中打造了高度可配置的硬件解决方案,使高通能够将AI解决方案从智能手机扩展到更多业务线。

比如面向汽车、云端等高性能场景,高通可以调整Hexagon处理器内的加速器和内存组件,还可以拼接多个Hexagon处理器,通过更多Hexagon处理器协同工作实现性能的拓展提升。

一句话总结就是,高通的技术IP面向毫瓦级和微瓦级功耗需求设计,能效优势明显,而这一优势也可以在引入到高性能终端时得到规模化扩展,这是高通在AI硬件解决方案层面的独特优势之一。

可以说,第七代高通AI引擎这一硬件已经构成了高通汽车、物联网、XR等所有不同业务AI能力扩展的真正核心。

2、一次开发,就能拓展至所有高通平台产品

除了硬件,在AI软件领域,端侧AI的落地还存在更大的挑战,为此高通也做了深入布局。

就在今年上半年,高通发布了前文提到的高通AI软件栈,值得一提的是,高通借助这一单一软件栈,实现了对所有产品线的覆盖。

高通AI软件栈,图片来源:高通

高通AI软件栈支持包括TensorFlow Micro、TensorFlow、Pytorch和ONNX在内的所有主流开发框架,支持所有的AI runtimes和操作系统,能够提供高通AI引擎Direct、高通神经网络处理SDK、开发者库、编译器等众多开发工具。

用更直观的话来说就是,高通让开发者和客户可以根据自己的实际需求进行模型的开发和优化,高通AI软件栈,是对AI开发生态的一次重要赋能。

借助AI软件栈,开发者们在智能手机领域开发的软件可以快速、高效地扩展至汽车、XR、可穿戴设备等丰富产品线进行使用。

“一次开发,就可以将解决方案跨高通所有产品线进行迁移”是高通在AI软件领域的独特优势之一。

三、技术武器库展露冰山一角,端侧AI让设备真正能“进化”

这些软硬件解决方案的独特优势,让端侧AI的应用更具有可行性。其实我们现在看到的,只是高通技术武器库中的一角,高通研发团队对于AI技术的研发远比我们看到的更加深入,并且对于未来一些前瞻性技术也进行了积极探索。

虽然深度神经网络的出现,让AI技术在近些年迎来了跨越式发展,但AI模型越来越大、为了应对更多场景变得越来越冗余的问题愈发凸显。轻量化的模型需求,变得日益迫切。

针对这一挑战,高通一直在模型压缩技术上进行着持续投入,目前高通能够实现从神经网络中移除可能冗余的部分,从而实现对模型的压缩。

此外,通过对量化技术、编译器技术的投入,高通让AI可以在既定功耗下处理更多任务。

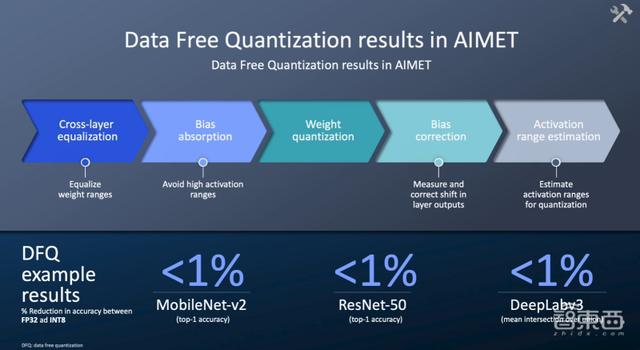

这其中非常值得一提的是高通在AI模型增效工具包(AIMET)内开发了无数据量化。

无数据量化表现,图片来源:高通

在MobileNet-v2、ResNet-50和Deeplabv3等代表性测试中,无数据量化技术可以将模型从FP32转化为INT8,但精度损失可以控制在1%以内。这种转化而来的模型可以实现16倍的能效比提升。

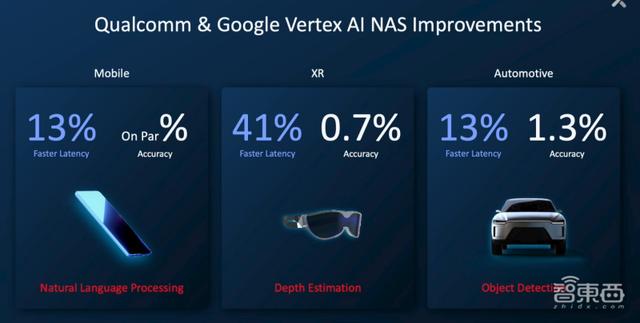

高通还与谷歌就Google Vertex AI解决方案的神经网络架构搜索能力展开了合作,并取得了比较直观的成果。

比如在移动端的自然语言处理方面,高通在不影响模型精度的情况下将任务处理的时延降低了13%;而针对汽车领域中的物体检测用例,时延改善了13%并且精度提升1.3%,针对特定的汽车用例,神经网络架构搜索带来的优势非常明显。

高通与谷歌就Google Vertex AI解决方案的神经网络架构搜索能力展开合作,图片来源:高通

在脚踏实地丰富自身AI技术武器库的同时,高通同样也会仰望星空。

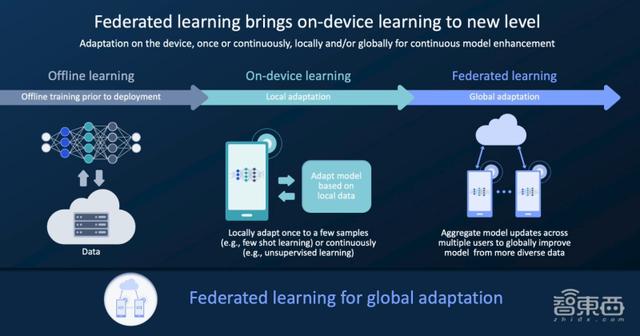

今天,AI技术逐渐从云端转移到边缘,但实际上AI边缘学习的效果依然比较有限。展望未来,端侧AI必然会加速落地,高通希望下一步能够实现完全分布式的AI,能够在终端上进行推理和一定程度的学习工作。

端侧AI能够让智能设备具有端侧学习能力,这样做的优势是显而易见的。

如果我们对一个模型进行多次训练,经过训练的模型训练数据和测试数据会有较大差距,这会导致模型无法充分泛化,而端侧学习可以让我们根据需求个性化数据。与此同时,所有训练和测试数据都能够留在终端上,实现数据隐私保护。

在AI端侧学习领域,小样本学习和联邦学习是高通端侧AI能力开发的两个非常有代表性的研究方向。

通过联邦学习,云端会向终端下发模型,而终端会基于本地数据进行优化调适,将模型再发回给云端,从而最终实现全局模型的改进。

联邦学习,图片来源:高通

以汽车为例,汽车上有各种摄像头、激光雷达、声呐,以及可以显示精确位置的3D地图,这些用例都可以应用AI进行联邦学习,从而持续提升驾乘体验。

通过联邦学习的案例我们能够看到,智能汽车就是端侧AI应用效果最为明显的案例之一,而不论是面向手机、汽车、XR还是物联网设备,端侧AI的落地都意义重大。

结语:高通AI“大一统”战略规模初显

具有出色能效比、高灵活拓展性的高通AI引擎,和高通AI软件栈所提供的高效便捷开发能力,让高通在端侧AI应用领域走在了行业前列。

凭借“统一的技术路线图”,从手机、汽车到XR,高通给自家各条产品线都赋予了AI能力加持的优势,并让这些优势能够以便捷的方式充分扩展至所有业务中。

当然,目前我们能够实现的AI能力的确还只是冰山一角,仍然有比较大的提升空间,也许,这便是AI技术的魅力所在吧,它让我们始终充满期待。

,