近日,谷歌文档中一项由人工智能驱动的“辅助写作”(assistive writing)功能在外网引发了热议。

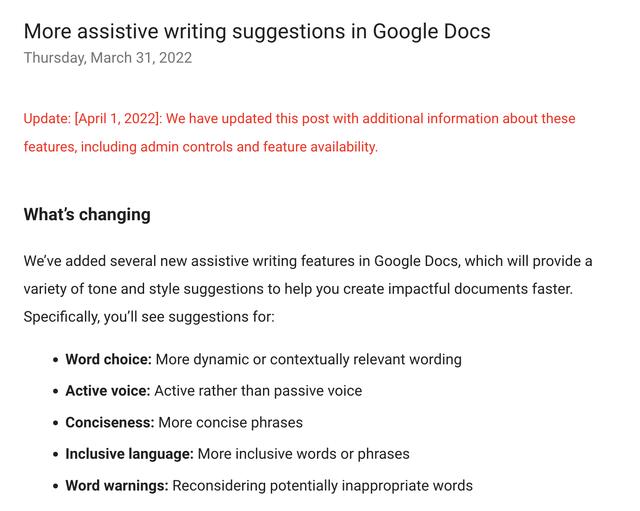

据多家海外媒体报道,在四月初,谷歌文档上线了用AI检测用户文档词汇并给出修改建议的辅助写作功能。这一新工具不仅会为谷歌文档用户提供系统认定表达更佳的词汇,还能帮助用户修改润色文章中的语法。

值得注意的是,谷歌这次更新升级的辅助功能会因文档中具有潜在歧视性或不恰当表达,为用户弹出相应的修改建议,提醒用户使用更“政治正确”的“包容性词汇”。

从其官网了解到,谷歌声明将避免写作者在文档中使用不必要的带有性格偏见、暴力色彩的词汇。其目的在于加强文本内容包容性和多样性,从而更好地为全球读者的阅读服务。

该功能上线后,有多名用户在社交软件Twitter上展示了自己在使用过程中文档出现的“包容性”弹窗。例如“housewife”被建议更改为“stay-at-home-spouse”,“policeman”则应换成“police officer”,其他的单词还有“landlord”、“motherboard”、“fireman”等都弹出了“包容性警告”。

谷歌文档的算法也对美国前总统约翰·F·肯尼迪在就职演说中使用“for all mankind”一词提出了异议,并建议将其替换为“for all humankind”。

据《今日俄罗斯》报道,自2020年以来,谷歌就要求其员工在代码和文档中使用这种包容性语言,并发布了一份详尽的禁用词列表。在谷歌的规定下,“black box testing”(黑盒测试)变成了“opaque box testing”(不透明盒测试),“man hours”被“person hours”取代,“guys”则被严格禁止使用。

而现在,这项功能使用范围拓展到了用户。不过,南都记者从官网了解到,“包容性语言”功能暂时适用于谷歌Workspace软件(谷歌文档企业版)的企业用户。

虽然这一功能用户可以关闭,但它体现的“语言监管”还是引起了用户的反弹,以及隐私和反审查活动人士的警觉。

隐私保护运动组织“老大哥观察”(Big Brother Watch)的负责人西尔基卡洛(Silkie Carlo)针对这一功能发言称,“这种言论监管是十分笨拙、令人毛骨悚然和错误的……像这样的侵入性技术破坏了隐私、言论自由和日益增长的思想自由。”

对谷歌上线的辅助写作功能,有学者也提出了质疑。“如果‘landlord’是更好的选择,它在小说中更有意义、更具叙事性,那该怎么办?”学者拉扎尔拉迪克面对英国《每日电讯报》时采访问,“所有书面作品——包括书面艺术形式,如小说、歌词和诗歌——都应该遵循同样无聊的模板吗?”

除了被认为“侵犯思想自由”、“扼杀表达”以外,这一功能执行中存在的另一漏洞也引发了争议。据《Vice》杂志测试发现,当在文档中输入三K党(即Ku Klux Klan,美国民间排外团体)前领导人大卫·杜克(David Duke)的采访稿时,文档中频繁出现的nigger(指代黑人的具侮辱性的词汇)一词,谷歌语言助手并没有对此出现任何弹窗警告。

事实上,算法偏见和歧视一直是计算机算法伦理研究方面的争议点。去年,有人曾披露过谷歌翻译中存在的性别偏见。

作者Sourojit Ghosh在文中指出,由于英语中使用性别代词(he、she)和性别中性代词(they、them),而孟加拉语中只使用性别中性代词,如সে (人称代词,发音为“shey”),因此当从孟加拉语翻译成英文时,谷歌翻译不仅将性别赋予原本性别中立的代词,其中还包含强制执行的性别刻板印象来实现。

至今,南都记者去测试上述情况后发现,谷歌翻译中存在的这一性别偏见依旧存在。

从这两次事件来看,谷歌在处理语言上存在的偏见和歧视事实上面临着两难的困境。它不仅会因为存在的偏见和歧视遭到质疑,然而,谷歌这次旨在消除偏见与歧视的努力也同样有着执行上的困难以及争议。

对此,谷歌公司一位发言人回应称,辅助写作功能正在“不断演变”。他表示,“辅助写作使用语言理解模型,它依赖数百万个常用短语和句子来自动学习人们如何交流。这也意味着它们可以反映人类的一些认知偏见。”

他补充道,“我们的技术一直在进步,我们还没有(可能永远也不会)一个完整的解决方案来识别和缓解所有不必要的单词关联和偏见。”

编译/综合:实习生杨曦霞 南都记者蒋琳

,